|

|

|

|

全部课程 >人工智能 |

|

GPU图像处理核心技术实战 |

511 次浏览  5 次 5 次

|

|

|

| 时间地点:北京、上海 深圳根据报名开班 |

| 课程费用:4800元/人 |

|

|

|

| 企业内训:可以根据企业需求,定制内训,详见

内训学习手册 |

|

|

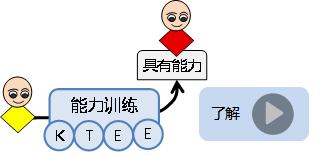

认证方式:

培训前了解能力模型。

培训后进行能力评测:

在线考试

能力分析,给出学习建议

合格者颁发证书,作为职业技能资格证明

|

|

|

|

本课程首先讲解GPU编程基础与核心算法并行化,并进行编程实践;然后讲解性能优化与完整流程构建。

|

| 培训目标: |

通过课程学习,可以:

- 深入理解GPU并行计算架构与编程模型

- 掌握CUDA(或OpenCL)编程的核心概念与流程

- 能够将经典图像处理算法重构为并行算法,并在GPU上实现

- 学会分析和优化GPU内核性能,规避常见陷阱

- 了解主流GPU图像处理库(如NPP, OpenCV CUDA)的使用

|

| 培训对象:希望将图像处理算法从CPU移植到GPU并实现加速的开发者,对高性能计算和并行计算感兴趣的技术人员 |

| 学员基础:有一定C/C++基础 |

课程特点:

概念比喻 + 可视化演示 + 逐行代码讲解 + 指导性动手实验 |

| 培训内容:2天

|

| GPU架构与CUDA编程模型 |

CPU与GPU架构深度对比

为什么图像处理适合GPU?数据并行性

GPU硬件架构简析:SM、CUDA Core、内存层次(全局、共享、常量、纹理内存)

CUDA编程模型入门

主机(Host)与设备(Device)

线程层次结构:Thread, Block, Grid

你的第一个CUDA程序:内存分配、数据传输、内核启动

练习:

配置CUDA开发环境(Nsight, VS等)

编写一个简单的内核,将GPU上的数组每个元素乘以2,理解基本流程。

|

| 图像处理在GPU上的实现(I) |

GPU上的图像表示与内存管理

在GPU上存储图像数据(Pitch线性内存)

使用CUDA流(Streams)实现异步传输与并发执行

点操作与邻域操作的并行化

点操作(如亮度调整、颜色转换):每个线程处理一个像素

邻域操作(如卷积滤波):共享内存(Shared Memory)的引入与使用,解决数据复用问题

实现一个高效的GPU高斯滤波器

练习:

实现图像反色、灰度化、对比度调整的点操作内核

实现基于共享内存的3x3 Sobel边缘检测器或盒式滤波器,并与Naive版本进行性能对比

|

| 图像处理在GPU上的实现(II) |

全局操作的并行化

并行前缀和(Scan)在直方图计算中的应用

并行归约(Reduction)求图像最大值/最小值/均值

纹理内存的应用

纹理内存的特性:缓存、寻址模式、滤波

为何纹理内存适合图像处理?在几何变换(旋转、缩放)中的应用

练习:

使用并行归约算法计算图像的平均亮度

利用纹理内存实现一个图像旋转内核,体验其带来的便捷性与性能优势

|

| 性能优化与库的使用 |

GPU性能分析与优化指南

使用Profiler工具(如Nvidia Nsight Systems)查找性能瓶颈

优化策略:最大化内存吞吐量、保证计算吞吐量、隐藏延迟

Occupancy(占用率)概念与优化

利用现成GPU库加速开发

NPP:NVIDIA Performance Primitives for 图像与信号处理

OpenCV CUDA模块:在熟悉的OpenCV框架内调用GPU函数

练习:综合实战与优化-实时图像处理管道

|

| 多GPU与跨平台编程 |

多GPU计算简介

跨平台替代方案:OpenCL

OpenCL与CUDA的架构与编程模型对比

简介OpenCL编程流程d

|

|

| |

|

|

| |

|

|

|

511 次浏览  5 次 5 次

|

| 其他人还看了课程 |

|

|

|